Spesse volte si parla talmente tanto di un argomento che, difatti, l’attenzione pubblica si sposta dal suo significato intrinseco alla creazione di schieramenti ben definiti, di norma favorevoli o contrari al dibattito. Nell’ambito dei videogiochi, questo meccanismo si applica spesso all’introduzione delle nuove tecnologie che promettono di migliorare in maniera concreta l’esperienza dei giocatori, come ad esempio l’HDR. Cerchiamo allora di compiere un passo indietro, in modo da capire bene di cosa si tratta, e come questa tecnica può incrementare la qualità visiva dei giochi che verranno proposti sul mercato nel prossimo futuro.

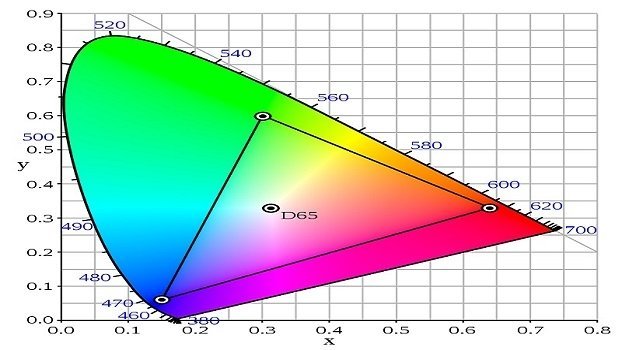

Vedo colori nuoviPer prima cosa, è utile sottolineare la differenza tra l’HDR cui ci si riferisce in ambito fotografico, e quello che invece interessa maggiormente noi giocatori. Nel primo caso, infatti, è possibile parlare di una tecnica che risulta in un processo di cattura e creazione delle immagini dai colori particolarmente vividi. Questa opzione, in effetti, riesce a creare foto d’impatto grazie allo scatto multiplo di fotografie con differenti esposizioni. Nella sua forma base, l’HDR fotografico presente nei comuni smartphone utilizza due varianti, una con esposizione in grado di catturare le luci alte, l’altra dedicata alle luci basse. Combinando le varie immagini, grazie al software della fotocamera oppure in secondo tempo tramite programmi di image editing, è possibile dunque produrre contenuti dalla forte carica visiva. Adesso, invece, veniamo al bello: l’HDR che investe la visione di film, serie tv e videogiochi è un processo legato certamente ai contenuti, ma anche agli apparecchi che hanno il compito di mostrarli. Nel momento in cui si parla di TV pensati per la fruizione di contenuti High Dynamic Range, infatti, vengono immediatamente citati i concetti di contrast ratio (conosciuto in italiano come intervallo di contrasto o rapporto di contrasto) e Wide Color Gamut (WCG). Il primo è spiegabile in maniera semplice: rappresenta l’intervallo compreso tra la luminanza massima e quella minima espresso in nit. L’occhio umano, di per sé, è in grado di percepire livelli di luminanza compresi grossomodo tra quelli presentati da un cielo stellato di notte, e l’esposizione diretta alla luce del sole. Le tecnologie attuali, invece, falliscono nel ricreare un range così elevato: grazie all’HDR, allora, sarà possibile proprio intervenire su questo parametro, aumentando la luminanza soprattutto delle zone più chiare. In questo modo, è possibile avere immagini evidentemente più realistiche, e con un profilo di brillantezza migliore. Accanto a tutto ciò, però, si inserisce una migliore comprensione del gamut. Questo elemento, in poche parole, rappresenta l’insieme dei colori riproducibili da un determinato panello. Ogni schermo, monitor e TV si muove all’interno di un gamut prestabilito, che evidentemente non combacia con lo spazio colore nella sua interezza (parliamo di gamut solo nei dispositivi atti a creare i colori, non a riprodurli, come fotocamere o periferiche simili). Lo standard attuale dei TV Full HD è rappresentato dal Rec. 709, sigla che indica i colori primari (evidentemente rosso, verde e blu) utilizzati dallo spazio colore sRGB. Grazie al Wide Color Gamut, in linea teorica è possibile coprire circa il 77,6% della totalità dei colori, a dispetto del 35,9% dell’attuale spazio colore sRGB. Tutto ciò, in altre parole, significa colori semplicemente mai visti prima sui propri TV, non solo più particolareggiati, ma soprattutto più realistici. Sembra tutto bello e facile? Così non è, perché bisogna fare i conti con altri elementi assai importanti: i pannelli, gli standard produttivi, e i contenuti e l’hardware.

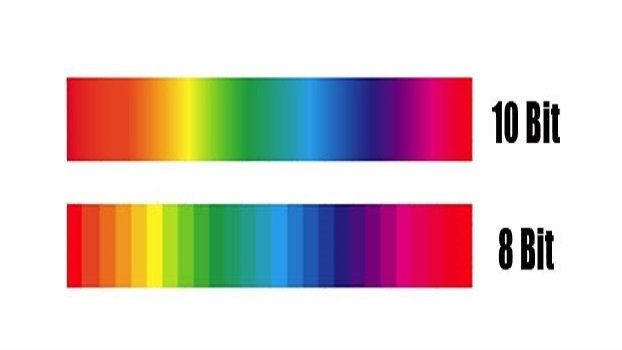

La resa dei bitL’avvento dell’HDR presuppone dunque l’ampliamento del contrast ratio e del gamut, ma tutto ciò può avere un suo senso solo se supportato da pannelli capaci di riprodurre tutte le sfumature adeguate. Il punto di partenza per capire di cosa stiamo parlando è il concetto di retroillumnazione dei display. Grazie a tecnologie come i quantum dots, o altre soluzioni del genere, è possibile creare dei colori primari puri, in grado di delimitare il gamut del dispositivo e la sua palette cromatica. A questo, va affiancato il modo in cui vengono codificati i segnali, definito in numero di bit per componente cromatica. Una classica codifica a 8 bit comporta 256 livelli per colore primario, da cui si arriva a 16 milioni di colori visualizzabili. Per poter aumentare il numero di tonalità rappresentate, dunque, è necessaria una codifica superiore, e per questo è essenziale che i nuovi TV siano dotati di pannelli almeno a 10 bit, capaci di riprodurre un miliardo di sfumature e quindi di andare oltre lo spazio colore dello standard Rec. 709/sRGB. In questo modo, infatti, è possibile superare il già citato 35,9% dei colori propri dello spazio sRGB, andando fino al 54% dei pannelli a 10 bit (in cui i livelli per colore primario arrivano a 1024). Superando questa soglia, arrivando a 12 bit, è possibile osservare oltre il 76% dei colori presenti in natura, pari a circa 68 miliardi. C’è da dire però che, come nel caso di ogni tecnologia emergente, l’HDR non presenta ancora uno standard del tutto dominante. Al momento, lo scontro sembra essere tra HDR10 e Dolby Vision. La prima alternativa offre supporto ai pannelli a 10 bit, luminosità teorica massima di 4.000 nit, ed è in sostanza la scelta utilizzata nella creazione di Blu-Ray Ultra HD. La seconda, che comporta però maggiori costi, si spinge fino al supporto ai pannelli a 12 bit, luminosità teorica massima che tocca i 10.000 nit, ed una maggiore elasticità teorica. Dolby Vision, infatti, riesce a gestire i contenuti HDR10, anche se al momento la sua diffusione è meno estesa, ed i problemi di visualizzazione di contenuti siano abbastanza diffusi. Di questi scontri tra standard la storia dell’elettronica di consumo è piena, e così come nel caso (ad esempio) di Betamax e VHS, o di Blu-Ray e HD DVD, il tempo ci dirà quali sono le circostanze che spingeranno i produttori da una parte piuttosto che dall’altra. D’altra parte i consumatori già da ora possono cercare di orientarsi in questa sorta di giungla tecnologica grazie alla certificazione Ultra HD Premium, di cui si possono fregiare giù alcuni apparecchi televisivi. Scegliere un TV di questo tipo, vuol dire avere a che fare con un dispositivo con pannello a 10 bit, e capace di supportare lo spazio colore DCI-P3, utilizzato per le produzioni cinematografiche e la creazione di contenuti Blu-Ray Ultra HD. Questo, a sua volta, è incluso all’interno dello spazio Rec. 2020, ad oggi utilizzato scarsamente, ma che rappresenta l’obiettivo per il futuro. Esistono poi dei requisiti relativi al livello di luminanza del nero, inferiore a 0,05 nit, così come di luminosità, pari a 1.000 nit.

Si, ma i contenuti?Quello che a noi interessa, messi da parte codifiche, gamut, contrast ratio e standard vari (per non parlare di risoluzioni), è capire come tutto ciò influenza la fruizione dei videogiochi. Partiamo con Xbox One S: la più recente console Microsoft consente la fruizione di contenuti HDR nello standard HDR10. Una soluzione, questa, che ha permesso peraltro di limare il prezzo finale, considerati i costi necessari all’implementazione dello standard Dolby Vision. Sugli apparecchi che lo consentono, dunque, i giocatori possono già da ora fruire di titoli in HDR, con tutti i vantaggi visivi che ciò comporta: un contrasto migliore, una brillantezza mai sperimentata prima, ed in generale un aspetto delle aree chiare decisamente più incisivo. L’approccio di Sony, invece, ha previsto l’inserimento di una sorta di HDR tramite l’aggiornamento del firmware delle attuali PlayStation 4. Ci esprimiamo in questo modo perché, evidentemente, i vincoli tecnici della console non permettono di parlare di vero High Dynamic Range; per prima cosa, PlayStation 4 presenta un’uscita HDMI di tipo 1.4b, mentre lo standard HDR10 richiede la versione 2.0 (presente invece su Xbox One S). Questo a causa non tanto del flusso di dati in sé (almeno finché si rimane a risoluzione 1080p), ma per via dei metadati aggiuntivi necessari alla definizione della maggiore dinamicità delle immagini. Quindi, l’unico modo per ottenere qualcosa che si avvicini al risultato dell’HDR è stato quello di agire sul picco di luminosità a livello software, considerato anche lo spazio colore nettamente più limitato determinato dall’utilizzo di codifica a 8 bit. Per questo motivo non c’è bisogno di creare giochi in maniera differente dal passato, almeno per l’attuale PlayStation 4. Per gli sviluppatori non cambierà niente, considerato che sarà la console a gestire in maniera differente l’illuminazione per dare un aspetto simile (ma di sicuro non uguale) a quello di un apparecchio HDR nativo, difatti ricampionando il segnale a 8 bit e andandone ad influenzare la dinamica. D’altra parte, è possibile già da ora sviluppare contenuti videoludici a 10 bit, ma la fatica non sarebbe ricompensata da risultati visibili. Constatati i limiti hardware, i contenuti visualizzabili su PlayStation 4 in ogni caso presenterebbero una dinamica limitata, e soprattutto costringerebbero a compromessi sul piano della risoluzione e del framerate. A voler essere un po’ cattivi (o forse realisti), si potrebbe dire che già ora, a 8 bit, molti titoli trovano difficoltà a proporre un’esperienza Full HD a 60 fps, per cui si può immaginare la situazione con una codifica a 10 bit. Naturalmente, tutto ciò dovrebbe cambiare con l’arrivo di PlayStation 4 Pro, che dovrebbe presentare l’hardware necessario al compito. Volendo divagare, in questo senso può apparire difficile pensare alla possibilità che non esistano differenze – anche sostanziali – tra giochi per PlayStation 4 e PlayStation 4 Pro, il cui supporto al 4K peraltro includerà tecniche di rendering supplementari quali come l’upscaling. In ogni caso, tornando all’High Dynamic Range, il messaggio dovrebbe essere chiaro: quello di PlayStation 4 non è considerabile un HDR puro, ma solo una gestione differente della gamma, che diventa così più estesa, pur rimanendo all’interno dei limiti dettati dalla codifica a 8 bit.

Sono in molti a paragonare l’importanza dell’arrivo dell’HDR a quella avuta, qualche anno fa, dal supporto all’introduzione della risoluzione Full HD. Il potenziale dato dall’arrivo di una gamma dinamica estesa, e l’introduzione di colori più realistici, nonché di una illuminazione in grado di far emergere in maniera migliore le immagini su schermo, sono sicuramente fattori capaci di scatenare un certo entusiasmo. È altrettanto ovvio, però, come si sia ancora in una fase in cui l’incertezza sugli standard è ancora presente, e la diffusione di TV con pannelli a 10 bit non è ancora capillare. Incuriosiscono anche le strategie di Microsoft e Sony: soprattutto la casa di Tokyo, al momento, offre una sorta di HDR in attesa che PlayStation 4 Pro porti soluzioni più performanti.

Tutto ciò, in ogni caso, senza dimenticarsi di una sana dose di banalità: se è vero che un pannello a 10 bit offre prestazioni migliori di quelli a 8 bit, è anche vero che potenzialmente un gioco per NES può essere ancora più divertente di un prodotto sviluppato oggigiorno. La speranza, allora, è che l’HDR e le altre tecnologie come il 4K – di cui parleremo in un prossimo speciale – costituiscano un contorno meraviglioso e fantastico agli elementi che, però, devono rimanere al centro della scena, ovvero i contenuti.